Jetzt haben wir endlich einen „SciFi-Moment“, Künstliche Intelligenz spricht mit uns und… ich merke sie labert Mist!

Naja, ganz so schlimm ist es nicht, zumindest labert sie nicht die ganzen Zeit Mist.

Ich nutze ChatGPT und Co schon recht intensiv und habe dabei dann manchmal das Gefühl: Da stimmt was nicht!

Und dann prüfe ich es und tatsächlich: Das ist so einfach nicht richtig, was mir da so verdammt überzeugend mitgeteilt wurde.

Sicheres Auftreten bei völliger Ahnungslosigkeit – Auch die KI scheint nach diesem menschlichen Motto zu agieren.

Halluzinationen – was steckt hinter dem Begriff?

Definition & einfache Erklärung

Eine KI-Halluzination passiert, wenn eine Künstliche Intelligenz etwas antwortet oder „erfindet“, das nicht stimmt oder gar nicht existiert – es sich für dich aber trotzdem so anhört, als wäre es richtig.

Stell dir vor, du fragst eine KI nach dem Weg – und sie erklärt dir mit absoluter Sicherheit, dass es in deiner Stadt eine „Brücke der Freiheit“ gibt. Klingt plausibel, klingt selbstbewusst, aber: Die Brücke existiert gar nicht.

Oder, dass die Glühbirne von Manfred Maier erfunden wurde.

Genau das sind Halluzination.

Warum Sprachmodelle überhaupt halluzinieren

Ganz einfach: Es liegt daran, wie Sprachmodelle ihre Ergebnisse ermitteln, nämlich nicht faktentreu mit tatsächlichem Wissen, sondern Wort für Wort. Im Detail habe ich das in diesem Artikel beschrieben.

Das ist, als würdest du einen Freund nach einer Zahl im Lotto fragen. Er weiß sie nicht, aber er rät mit einer sehr überzeugenden Miene.

Hauptursachen von KI Halluzinationen

Statistik statt Wahrheit

Modelle optimieren auf „wahrscheinlich nächste Wörter“ – nicht auf Faktentreue. Bestimmte Einstellungen wie Temperatur oder Länge können das Problem sogar verschärfen.

Schlechte oder veraltete Trainingsdaten

Wenn die Daten, mit denen das Modell trainiert wurde, fehlerhaft oder alt sind, entstehen logischerweise Fehler.

„Gefälligkeit“

Manche KIs lernen, dir zu gefallen, statt dir zu widersprechen. (ChatGPT ist ein Beispiel dafür). Sie spiegeln deine Überzeugungen wider – auch wenn die falsch sind.

Das kann Reinforcement Learning from Human Feedback (RLHF) passieren und ChatGPT ist hierfür ein prominentes Beispiel.

Fehlendes Bewusstsein & Selbstkritik

KI weiß nicht, dass sie etwas nicht weiß. Sie klingt selbstbewusst, selbst wenn sie komplett danebenliegt.

Fehlendes Bewusstsein & Selbstkritik

Ohne Zugriff verifizierte Daten oder vertrauenswürige Quellen, muss die KI raten. Und selbst wenn sie Zugriff hat, können schlechte Such-Strategien (z. B. falsche Dokumente) Fehler verstärken.

Welche Risiken entstehen durch Halluzinationen?

Risiken für Glaubwürdigkeit und Verantwortung

Wenn KI fehlerhafte oder erfundene Informationen liefert, kann das schwerwiegende Folgen haben. Wer sich blind darauf verlässt, riskiert rechtliche Konsequenzen, Vertrauensverlust und dauerhafte Schäden am eigenen Ruf.

Vielleicht hast du davon gelesen: Ein Anwalt in den USA zitierte in einem Gerichtsverfahren Urteile, die die KI schlicht erfunden hatte. Ergebnis: Sanktionen und ein massiver Reputationsschaden.

Risiken für Sicherheit und Wohlbefinden

Fehlerhafte Ausgaben oder gezielte Manipulationen können direkte Auswirkungen auf sensible Bereiche haben. Gerade in Medizin, Forschung oder sicherheitskritischen Anwendungen ist das Risiko besonders hoch, da hier Menschenleben und Gesundheit betroffen sein können.

In klinischen Tests zeigte sich, dass KI nicht nur Fehler macht – sondern auch Angriffsvektoren eröffnet. Sprich: Sie kann gezielt manipuliert werden, was in sensiblen Bereichen brandgefährlich ist.

Risiken für Effizienz und Geschäftsbetrieb

Unzuverlässige Antworten führen schnell zu Mehraufwand: zusätzliche Supportfälle, steigende Kosten oder Umgehungslösungen durch Schatten-IT. Am Ende können solche Probleme die Produktivität hemmen und ganze Prozesse destabilisieren.

So kannst du Halluzinationen reduzieren oder sogar vermeiden

Antworten überprüfen lassen (Selbstprüfung & Verifikation)

Lass die Antwort nochmal durch die KI selbst überprüfen. Ich öffne hierfür ein neues Chat-Fenster und fordere auf die Aussage zu überprüfen. Oder lasse die Antwort ganz einfach durch eine andere KI gegen checken.

Eine weitere Möglichkeiten, um Antworten einer Prüfung zu unterziehen wäre die Verwendung der Chain-of-Verification (CoVe) Methode.

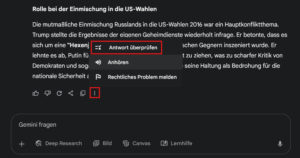

Google Gemini bietet inzwischen die Möglichkeit, dass man eine erhaltene „Antwort überprüfen“ kann, so dass Hinweise daruf gegeben werden, ob bzw. an welcher Stelle man nochmals recherchieren sollte.

Menschliche Kontrolle bei wichtigen Themen (Human-in-the-Loop)

Bei sensiblen Bereichen wie Finanzen, Medizin oder Recht darf man der KI nicht blind vertrauen.

Hier muss immer ein Mensch die Antwort prüfen, bevor sie genutzt wird.

Gesunden Meschenverstand nutzen (oder auch: MI nutzen 🧠)

Auch wenn es einfach und verlockend ist: Wir sollten grundlegende Dinge, die wir gelernt haben nicht vergessen: Quellen prüfen, verifizieren und selbst ein Bild machen.